O que impulsiona a próxima era da computação? Desde os primórdios da revolução digital, a humanidade tem testemunhado avanços extraordinários. No entanto, entre todas as inovações, surge uma que se destaca como o futuro da computação: a nuvem.

Neste artigo, exploraremos a trajetória da computação, desde as visões visionárias de Joseph Licklider em 1960 até os dias atuais, onde a nuvem se tornou uma peça fundamental no cenário tecnológico. Descubra como a computação em nuvem, prevista há 64 anos, se desenvolveu e conquistou seu lugar nas operações globais de empresas, impulsionando uma revolução na forma como utilizamos e acessamos recursos computacionais.

O futuro da computação está na nuvem

Várias invenções da humanidade entusiasmaram e impulsionaram a civilização, e cada pessoa tem a sua própria lista das invenções mais importantes. Mas tem uma que provavelmente está em quase todas as listas: a computação. Sua história é muito longa para ser contada aqui, mas seus benefícios foram reconhecidos desde muito cedo.

Em março de 1960, um cientista da computação chamado Joseph Licklider publicou um artigo na revista científica IRE Transactions chamado “Man-Computer Symbiosis“. No artigo, ele descrevia uma relação complementar (“simbiótica”) entre humanos e computadores em algum momento no futuro. Agora, sabemos que esse futuro já chegou, e que a computação faz parte de virtualmente tudo o que fazemos. Estamos em simbiose com ela e a computação é onipresente.

Isso aconteceu devido a vários fatores. Primeiramente, por causa do desenvolvimento das tecnologias que permitiram distribuir os recursos computacionais entre vários usuários simultaneamente. Também pelo progressivo barateamento desses recursos (armazenamento, processamento, telecomunicações). Por fim, devido ao surgimento de empreendimentos que oferecem esses serviços ao mercado global, a computação em nuvem se tornou uma solução acessível e econômica para todos.

A computação em nuvem foi prevista há 64 anos

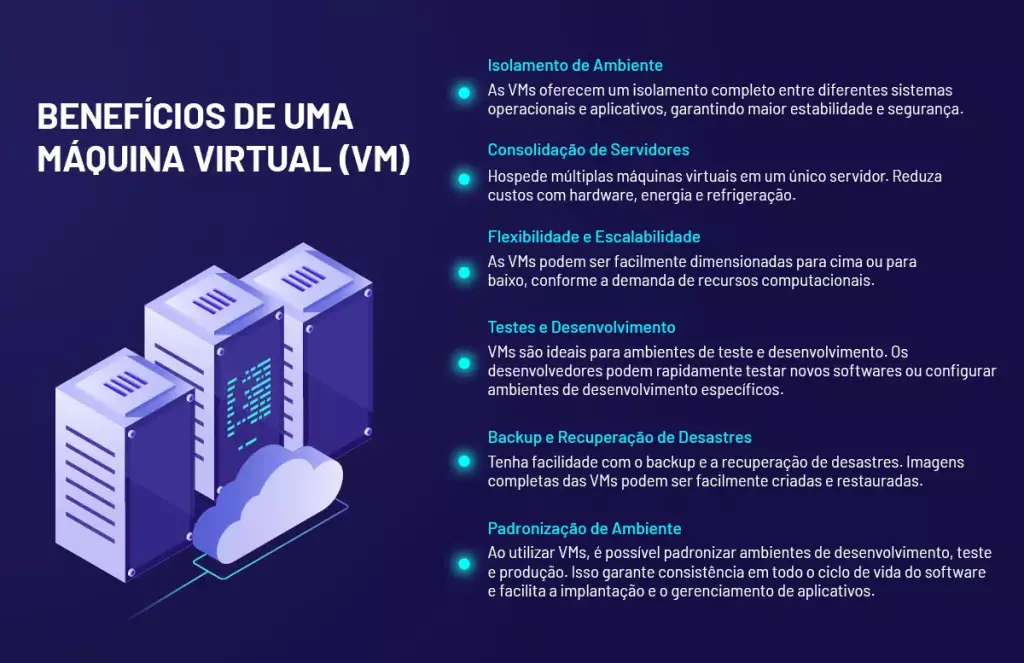

Mesmo que Licklider tenha mostrado em seu artigo alguns benefícios da computação distribuída, era impossível prever o quão avançados seriam esses serviços. Por exemplo, em poucos segundos poder criar uma máquina virtual (VM), um computador super rápido com tudo que uma pessoa física ou uma corporação precisam. Entretanto, trata-se de uma máquina virtual, ou seja, um computador virtual.

Outros cientistas dessa época, como John Backus, por exemplo – o inventor da linguagem FORTRAN -, já previam que seria possível compartilhar o tempo em um computador grande, de modo que ele pudesse ser usado como se fosse um conjunto de vários computadores menores. Exatamente como as VMs.

No intervalo entre essa época e hoje, a computação se desenvolveu e se expandiu para oferecer os recursos a cada vez mais pessoas. Pelo compartilhamento de tempo, o “time sharing”, evoluindo até as máquinas virtuais, que são computadores completos, para a finalidade que o usuário desejar.

Hardware acessível e redes em evolução

Nesse mesmo intervalo, ocorreram dois fenômenos: o barateamento do hardware e a evolução das telecomunicações e das tecnologias de rede. Aproximadamente de dois em dois anos, os processadores duplicavam em capacidade de processamento, enquanto seus custos diminuía. Simultaneamente, as telecomunicações foram se tornando cada vez mais digitais, mais velozes e mais baratas.

Tudo isso combinado permitiu que grandes corporações pudessem criar data centers para seu uso exclusivo. Uma dessas corporações, que desenvolvia datacenters para suas operações globais de comércio eletrônico, tinha nas mãos recursos com elasticidade on-demand em processamento, memória e armazenamento. Em 2003, ela concluiu que poderia oferecer esses recursos a desenvolvedores e empresas que preferissem utilizá-los remotamente, ao invés de comprar novos computadores. Era muito mais barato.

Esses recursos estavam em algum lugar da internet, e os usuários não saberiam dizer exatamente onde. Foi assim que nasceu a computação em nuvem, que essa empresa começou a comercializar em 2006. E assim estava criada a primeira nuvem pública.

A adoção da nuvem foi progressiva

A adoção da nuvem não foi imediata, gestores de TI nessa época costumavam dizer que processar em nuvem era simplesmente processar e armazenar no computador dos outros. Contudo, as grandes corporações, como os bancos, descobriram que nuvem era uma boa solução e construíram as suas: nasceram assim as nuvens privadas.

Ao utilizarem também nuvens públicas para operações não-estratégicas, criaram aquilo que se chama de “nuvem híbrida”. Pouco a pouco mais e mais empresas aderiram ao modelo de computação em nuvem, gastando em operações (OPEX) e não em capital (CAPEX), por várias razões, sendo duas fundamentais, porque era mais barato e porque a nuvem oferece a criação ou expansão instantânea de recursos, o que não existe no modelo tradicional.

Hoje, 18 anos depois depois da criação da primeira nuvem pública, a computação em nuvem também evoluiu em número de adeptos, em utilidade, em tecnologia: ela se tornou a ferramenta essencial de computação para milhares de empresas já estabelecidas, com necessidades de expansão da sua infraestrutura, assim como é essencial para uma enorme quantidade de startups que, ao adotá-la, puderam lançar empreendimentos sem investir fortunas em data centers proprietários.

Chegou a Nuvem da Huge Networks

Neste ano, a Huge Networks está trazendo para esses e outros tipos de clientes a sua plataforma de cloud, criada com características que se pode considerar o “estado-da-arte”. A nuvem da Huge já nasce com tecnologia de ponta para processamento, gestão, rede, nível de serviço e segurança, numa combinação que habitualmente não é encontrada em nenhum fornecedor. Apesar dessa qualidade nos recursos, o serviço tem uma precificação justa, transparente, e com o melhor custo-benefício do setor.

Os recursos incluem hypervisores high-end, servidores de última geração oferecendo garantia de performance e disponibilidade, backups e snapshots de máquinas virtuais para restauração a qualquer momento. Além de defesa in-house contra ataques de negação de serviço (DDoS) de até 40Gbps, com um SLA (service level agreement) de 99,99% de disponibilidade, graças à infraestrutura em data centers tier 3. A precificação é transparente e apresentada em tabela pública, variando conforme o número contratado de CPUs (quatro ou oito), memória (de oito a 32 GB) e armazenamento (de 140 a 420 GB).